Attacchi informatici che manipolano l’IA

Attacks- L’intelligenza artificiale è diventata ormai fondamentale e necessaria per migliorare l’efficienza operativa, automatizzare processi ripetitivi e complessi, e fornire analisi approfondite e in tempo reale dei dati. Questo permette alle aziende di prendere decisioni più informate, personalizzare l’esperienza del cliente e rispondere in modo più rapido e preciso alle sfide del mercato. Inoltre, l’IA sta contribuendo significativamente alla risoluzione di problemi globali, come il cambiamento climatico e la gestione delle risorse naturali, attraverso la modellazione predittiva e l’ottimizzazione delle risorse.

MODELLI IA: PREDITTIVI E GENERATIVI

Nel campo dell’intelligenza artificiale (IA), esistono diverse tipologie di modelli che vengono utilizzati per affrontare vari problemi e sfide. Tra questi, i modelli predittivi e generativi sono tra i più importanti e diffusi.

Modelli Predittivi: L’IA predittiva è progettata per fare previsioni basate su dati storici. Il suo obiettivo principale è prevedere eventi futuri o classificare nuovi dati in base a pattern e tendenze identificate nei dati passati.

Modelli Generativi: L’IA generativa è progettata per creare nuovi dati che imitano la distribuzione dei dati di addestramento. L’obiettivo è generare nuovi contenuti che sembrano realistici o naturali rispetto ai dati esistenti.

ATTACCHI AI MODELLI PREDITTIVI

ATTACKS POISONING

Gli attacchi di avvelenamento mirano a compromettere il processo di addestramento del modello inserendo dati malevoli nel set di addestramento. Questi dati manipolati possono alterare il comportamento del modello, portando a previsioni errate o al malfunzionamento del sistema. La necessità di ottenere grandi quantità di dati di addestramento aumenta le possibili modalità di attacco e rende più difficile adottare misure di difesa. Spesso i dati di addestramento sono pubblici, cercati e scaricati da Internet, ma questo rende molto difficile garantire che la sorgente sia qualificata, lecita e non a sua volta oggetto di attacco o direttamente creata dall’attaccante

ATTACKS EVASION / ADVERSARIAL ATTACKS

Gli attacchi di evasione compromettono l’integrità dei dati generati da un modello di intelligenza artificiale (AI) e sono particolarmente insidiosi. Questi attacchi consentono agli aggressori di manipolare il comportamento del modello utilizzando dati di input che appaiono legittimi e molto simili ai dati di addestramento. Questa somiglianza rende estremamente difficile rilevare gli attacchi semplicemente analizzando i dati di input del modello. Per individuare queste vulnerabilità, è necessario adottare un approccio simile a quello dei Red Team. Un Red Team è un gruppo di esperti di sicurezza che simula attacchi reali per identificare le debolezze del sistema, comportandosi esattamente come farebbe un vero attaccante. Questa metodologia consente di valutare in profondità la sicurezza del modello di AI e di sviluppare strategie efficaci per mitigare i rischi associati agli attacchi di evasione.

ATTACKS EXTRACTION / RECONSTRUCTION

Gli attacchi di estrazione, noti anche come attacchi di ricostruzione, rappresentano una categoria di attacchi informatici mirati a recuperare informazioni sensibili o a duplicare un modello di intelligenza artificiale (AI) sfruttando l’accesso alle sue previsioni. Questi attacchi possono compromettere la proprietà intellettuale del modello e la privacy dei dati utilizzati per addestrarlo. L’obiettivo principale di questi attacchi è ricostruire o duplicare il modello AI utilizzando le informazioni ottenute dalle sue risposte. Gli attaccanti cercano di capire la logica interna del modello e di recuperare dati sensibili che il modello ha appreso durante l’addestramento.

ATTACCHI AI MODELLI GENERATIVI

Gli ATTACCHI DI ABUSO comportano l’inserimento di informazioni errate in una fonte legittima, come una pagina web o un documento online, che l’intelligenza artificiale successivamente utilizza. A differenza degli attacchi di avvelenamento, che mirano a corrompere i dati di addestramento, gli attacchi di abuso forniscono all’IA informazioni errate da una fonte autentica ma compromessa. Questo tipo di attacco può adattarsi dinamicamente per manipolare l’IA in base al cambiamento degli obiettivi dell’attaccante.

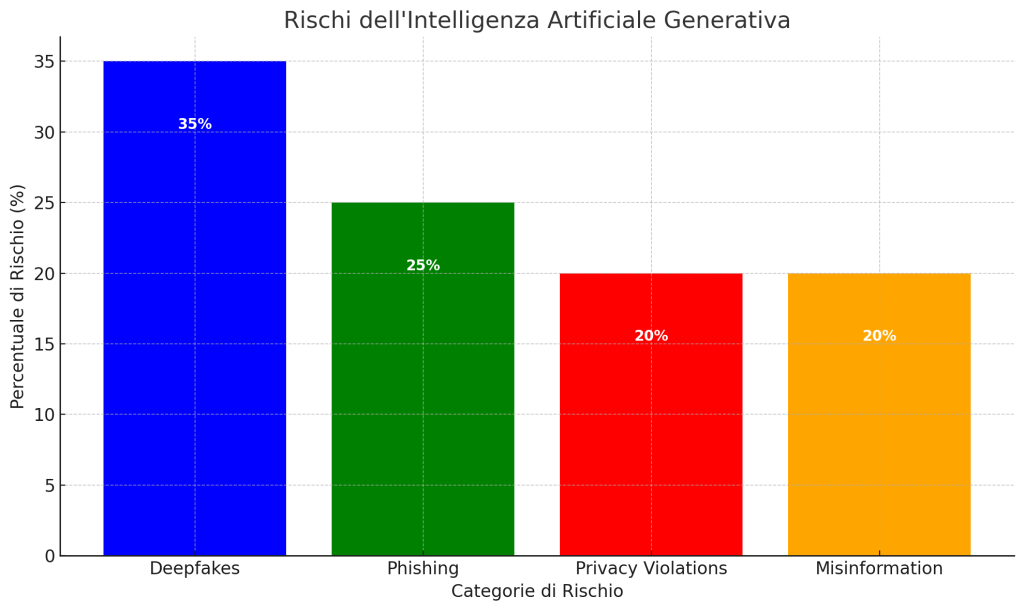

Questo grafico illustra i principali rischi associati all’uso dei modelli di intelligenza artificiale generativa, con una particolare enfasi su deepfakes, phishing, violazioni della privacy e disinformazione. Come evidenziato, ogni categoria di rischio presenta sfide uniche che richiedono soluzioni specifiche e mirate per garantire la sicurezza e l’integrità dei sistemi di IA.